생성형 AI인 ‘챗GPT’, ‘바드’, ‘하이퍼클로바 X’ 등의 기본이 되는 대규모 언어모델(LLM)이 학습데이터에 따른 정치적 편향을 지니고 있고, 향후 정치나 선거 등에 영향을 미칠 수도 있다는 연구결과가 나오고 있다.

최근 한국언론진흥재단(언론재단)의 KPF 미디어브리프 <“챗GPT, 생성AI 중 가장 진보적(Liberal)으로 나타나”>(오세욱 언론재단 책임연구위원)에 따르면 대규모 언어모델은 각각 학습한 자료들이 비슷하면서도 다르고 이에 따라 각기 다른 답변 성향을 나타내는데 여기엔 인종, 성별, 종교는 물론 정치적 편향성도 포함된다는 게 최근 관련 해외 연구들에서 확인된다. 실제 보고서가 소개한 챗GPT의 좌파 성향을 보여준 연구(<More human than human: measuring ChatGPT political bias>, 모토키 등) 등에선 챗GPT가 미국 민주당, 브라질 룰라 대통령, 영국 노동당에 대해 심각하고 체계적인 정치적 편향을 보인다는 내용이 포함돼 있다.

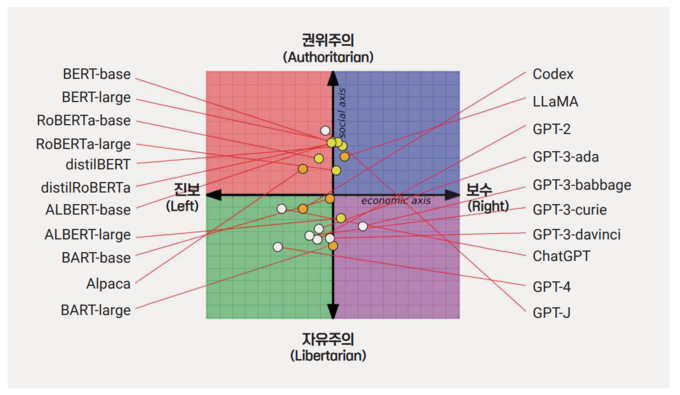

어떤 생성형 AI에 질문하는지에 따라 대규모 언어모델의 정치적 성향이 달리 나타난다는 연구(<From Pretraining Data to Language Models to Downstream Tasks: Tracking the

Trails of Political Biases Leading to Unfair NLP Models>, 펭 등)도 나왔다. 14개 대규모 언어모델에 정치적으로 민감한 62개 문장에 대한 동의여부를 물어 정치 성향을 조사했더니 오픈AI의 ‘챗GPT'와 'GPT-4'가 가장 좌파적인 자유주의자처럼 답변했고, 메타(Meta)의 '라마(LLaMA)’가 가장 우파적인 권위주의자처럼 반응했다. 구글의 언어모델 ‘버트(BERT)’가 오픈AI의 GPT 모델보다 사회적으로 더 보수적이란 사실도 발견됐는데, 보고서는 “구형 BERT 모델이 더 보수적인 경향이 있는 책을 학습한 반면, 최신 GPT 모델은 더 자유로운 인터넷 텍스트를 학습했기 때문에 이러한 결과가 나타난 것으로 추정됐다”고 적었다.

위 연구 다음 단계에선 좌파와 우파 성향으로 뉴스미디어와 소셜미디어 데이터를 구성한 후 대규모 언어모델에 학습을 시켜 학습데이터가 정치적 편향에 미치는 영향을 확인하고자 했는데 그 결과 학습데이터에 따라 언어모델의 정치적 편향성이 강화된다는 사실을 발견했고, 언어모델의 정치성향별 혐오발언, 허위정보에 대한 반응을 측정해 “대규모 언어모델의 편향성을 완화하기 위해 데이터 세트에서 편향된 콘텐츠를 제거하는 것만으로는 편향성 완화에 충분하지 않다”는 점을 확인하기도 했다.

이와 관련해 미국 대부분의 주요 뉴스 사이트는 AI의 웹 크롤러가 ‘저작권’을 이유로 자사 기사를 수집하지 못하도록 차단하고 있지만 폭스뉴스, 데일리콜러, 브레이트바트 등 보수 성향 언론은 구글의 AI데이터 수집 봇, 오픈AI의 GPT봇 등을 차단하지 않고 있었다는 조사결과도 언급됐다. 조사 혹은 연구진은 ‘보수 성향 사이트 콘텐츠를 집중 학습시켜 생성AI 정치적 편향성을 보완하기 위한 시도’일 수 있고, 이 같은 학습이 ‘모델 매개변수에 영향을 미칠 수 있다’는 의견을 내놨지만 AI기업에선 ‘특정 분야나 단일 사이트는 전체 학습 데이터 중 극히 일부라서 측정 가능한 영향을 미치지 않는다’고 주장하며 입장이 갈렸다. 다만 보수 성향 일부 매체(데일리 와이어)에선 ‘언어모델의 정치적 편향성 완화 목적에서 GPT봇 및 기타AI봇의 기사 수집을 차단하지 않고 있다’는 말이 나오기도 했다.

이 같은 연구들은 현 생성 AI들이 편향을 지니고 있고, 향후 학습 데이터에 따라 달라질 수 있는 가능성을 전제한다. AI 학습 데이터와 관련해 기사 저작권 이슈에 따라 AI 봇을 차단하는 일은 국내 언론에서도 늘고 있는데 그 결과가 당장은 아니더라도 장기적으로 생성AI의 결과물에 영향을 미칠 여지도 충분히 있다. 언론재단은 “대규모 언어모델을 만드는 곳에서는 뉴스는 극히 일부 데이터기 때문에 특정 성향이 강화되거나 완화될 가능성이 작다고 주장하지만, 특정 편향을 보이고 있는 것은 사실”이라며 “학습에 사용되는 데이터의 출처를 공개해 이에 대한 검토가 가능하게 할 필요가 있다”고 제언했다. 이어 “생성AI가 대중화될수록 정치, 사회 문화 등 대부분의 영역에 미치는 영향력이 커지기 때문에 학습 과정에서 생긴 편향이 우리 사회에 미치는 영향을 미리 검토할 필요가 있기 때문”이라고 덧붙였다.

최승영 기자의 전체기사 보기Copyright @2004 한국기자협회. All rights reserved.